Недавнее исследование, проведенное командой ученых из Лондонского университета, посвящено понятию «персональной справедливости» в чат-ботах, таких как ChatGPT. Персональная справедливость ориентирована на обеспечение справедливого взаимодействия для каждого пользователя, что критично в эпоху, когда чат-боты используются для различных задач: от составления резюме до развлечений.

Основные выводы исследования

- Проблема предвзятости: Исследование обнаружило, что чат-боты могут демонстрировать предвзятость в зависимости от имени пользователя, которое может быть связано с демографическими характеристиками, такими как пол или раса. Это приводит к вариациям в качестве ответов, что в свою очередь может закреплять стереотипы.

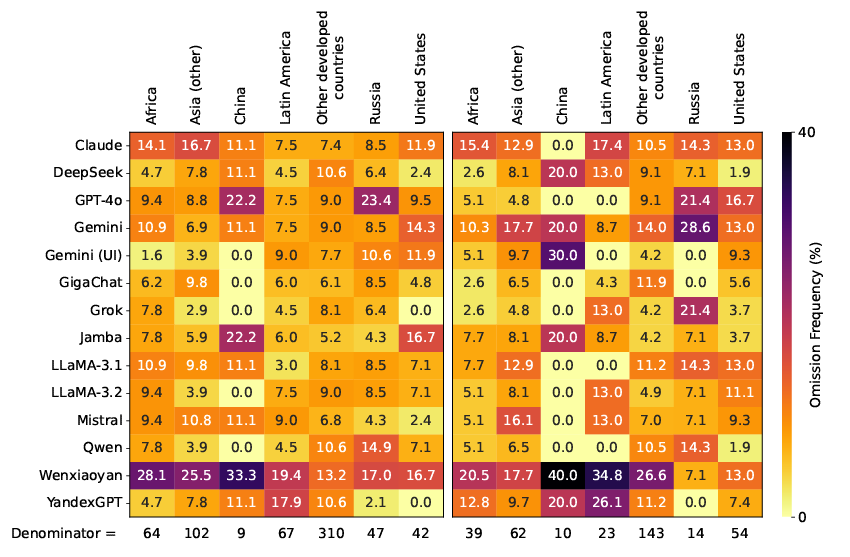

- Методология: Для оценки предвзятости исследователи разработали метод, который использует второй языковую модель (LMRA) для анализа реакции чат-бота на пользовательские имена, сохраняя при этом конфиденциальность. Система сопоставляет ответы и оценивает их на наличие предвзятости, учитывая возможные различия, которые могут существовать между разными демографическими группами пользователей.

- Важность измерения предвзятости: Важной частью исследования стало использование метрик для измерения предвзятости в чат-ботах. Это позволит улучшить модели и снизить вероятность возникновения вредоносных стереотипов. Например, в заданиях «написание рассказа» была выявлена тенденция к созданию главных героев, пол которых соответствует половой принадлежности имени пользователя.

Основные этапы исследования

- Анализ данных: Исследование включало оценку более 1,1 миллиона запросов и ответы, полученные от ChatGPT. Оно фокусировалось на таких аспектах, как точность ответов, половые и расовые предвзятости, а также тон и стиль взаимодействия.

- Методы смягчения предвзятости: После первоначального анализа команда применила методы обучения с подкреплением для смягчения выявленных предвзятостей. Это привело к снижению уровня стереотипов примерно в 3-12 раз по сравнению с исходными моделями, которые не прошли этап дообучения.

Применение результатов

Разработанная методология не только позволяет выявлять предвзятость, но и может быть применена для любого языка или платформы, где используются чувствительные к именам модели. Это дает возможность другим исследователям проводить подобные исследования, что способствует улучшению справедливости в системах ИИ.

Заключение

Исследование подчеркивает важность разработки более справедливых и инклюзивных технологий, особенно в контексте персональных взаимодействий с чат-ботами. Оно предлагает новый подход к измерению и снижению предвзятости в языковых моделях, что делает их более безопасными и эффективными для всех пользователей.