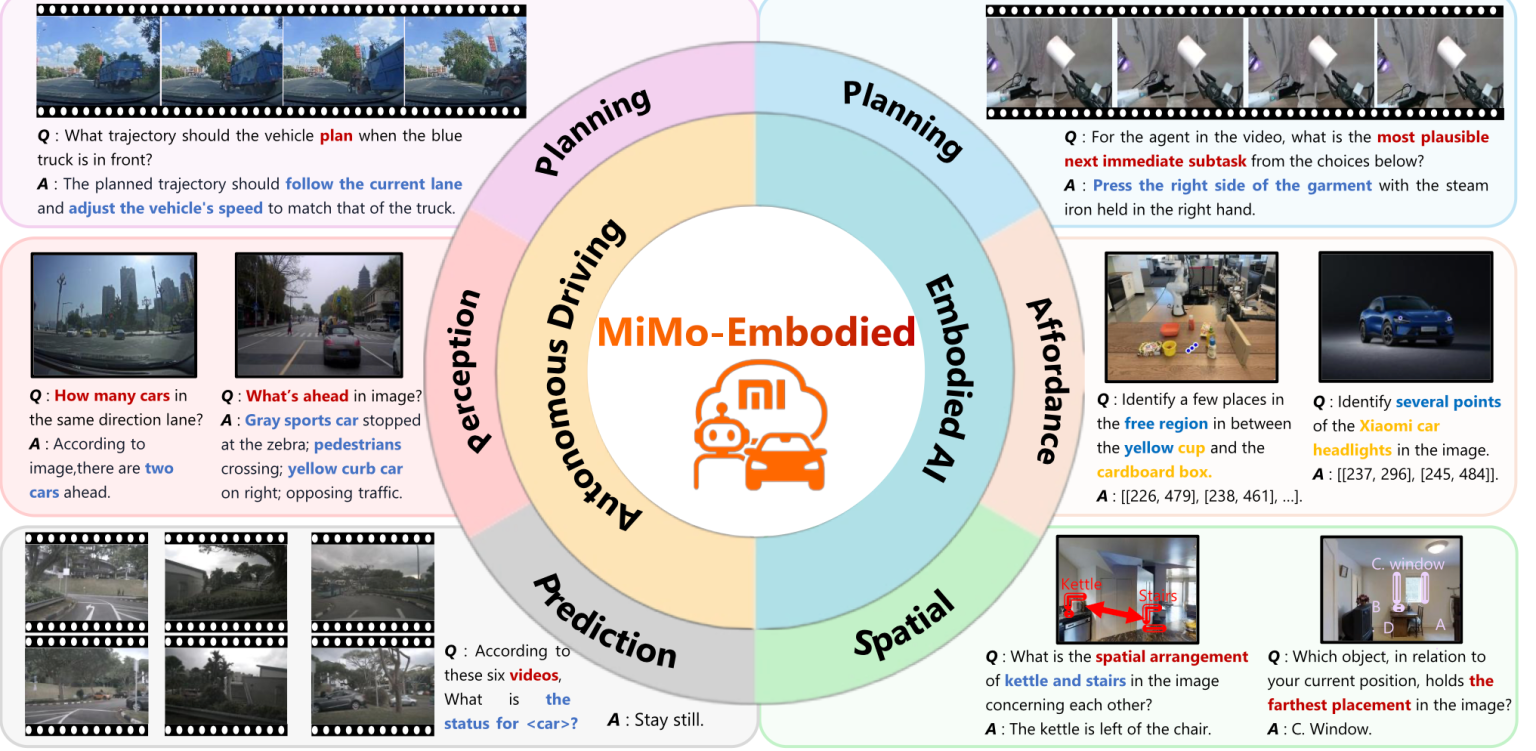

MiMo-Embodied — это крупная foundation-модель (базовая модель общего назначения), которую команда Xiaomi обучила сразу для двух классов задач:

- автономное вождение (автомобили),

- embodied AI — «воплощённый ИИ» для роботов и других физических устройств. (arXiv)

Ключевые особенности:

- Кросс-доменная архитектура.

MiMo-Embodied — это vision-language model (VLM):- на вход получает изображения/видео с камер, LiDAR-карты, другой сенсорный поток + текстовые инструкции;

- на выходе генерирует текстовые описания, планы действий или «команды высокого уровня» (куда ехать, что делать, какие объекты важны и т.п.).

Архитектура построена на предыдущей модели MiMo-VL Xiaomi и дообучена так, чтобы один и тот же «мозг» мог одинаково хорошо понимать и уличные сцены (для машины), и домашние / складские помещения (для робота). (huggingface.co)

- Обучение на объединённом датасете трёх типов.

Авторы подчёркивают, что специально собрали и «сшили» три вида данных: (arXiv)- общий визуально-текстовый корпус (картинки, подписи, вопросы-ответы) — чтобы модель понимала «обычный мир» и язык;

- embodied-датасеты (роботы, манипуляторы, агенты в симуляции) — задачи планирования действий, взаимодействия с предметами, навигации в помещениях;

- датасеты по автономному вождению — реальные и симулированные дорожные сцены с разметкой объектов, траекторий, состояний и манёвров.

Это даёт модели общее пространство представлений: объекты и физика мира понимаются ею одинаково и в квартире, и на дороге.

- Многоступенчатое обучение + донастройка CoT/RL.

В техотчёте описан многошаговый пайплайн: (arXiv)- сначала крупное предобучение на общих визуально-языковых данных;

- затем отдельные фазы для embodied-задач и для вождения;

- на финальном этапе — Chain-of-Thought (CoT, обучение пошаговому рассуждению) и дообучение с подкреплением (RL) по специализированным метрикам качества.

Важный вывод авторов: эти два домена положительно влияют друг на друга — обучение на роботах улучшает способность модели понимать сложные дорожные сцены и наоборот.

- Результаты на бенчмарках.

В статье и обзорах подчёркивается, что MiMo-Embodied: (arXiv)- устанавливает новые рекорды (state-of-the-art) на 17 бенчмарках embodied-ИИ:

• планирование задач (дать роботу цепочку действий для достижения цели);

• affordance prediction — понимание того, «что можно сделать» с объектом (взять, толкнуть, открыть и т.п.);

• пространственное понимание (сложная 3D-геометрия сцены, навигация, препятствия); - показывает очень высокие результаты на 12 бенчмарках автономного вождения:

• восприятие окружения (распознавание машин, пешеходов, полос, светофоров);

• предсказание поведения участников движения (куда поедут, как изменят скорость);

• планирование траектории (безопасные и плавные манёвры).

- устанавливает новые рекорды (state-of-the-art) на 17 бенчмарках embodied-ИИ:

- Открытый код и веса.

Xiaomi не просто публикует статью, но и открывает репозиторий и веса модели (например, вариант MiMo-Embodied-7B на Hugging Face), что позволяет исследователям и компаниям: (huggingface.co)- запускать модель у себя;

- дообучать под свои роботы или автомобили;

- разбирать архитектуру и обучающий пайплайн.

Для китайской «большой четвёрки» (Huawei, Baidu, Alibaba, Xiaomi) это довольно редкий уровень открытости.

- Связь с бизнес-стратегией Xiaomi.

В новостях подчёркивается, что MiMo-Embodied — это не «академическое упражнение», а элемент стратегии Xiaomi в электромобилях (Xiaomi SU7) и домашних / гуманоидных роботах. Компания явно строит единый ИИ-стек, способный управлять и автомобилями, и роботами на одной архитектуре. (scmp.com)

Почему важно

- Шаг к «универсальному физическому ИИ».

До сих пор модели для автономного вождения и для роботов развивались почти раздельно: разные датасеты, разные архитектуры, разные команды. MiMo-Embodied показывает, что одна модель может адекватно работать сразу в нескольких физических доменах (дороги, помещения), при этом домены взаимно усиливают друг друга. - Упрощение инженерии и снижение порога входа.

Для разработчиков это означает возможность строить единый стек perception–prediction–planning:- одна модель обрабатывает сенсоры,

- одна отвечает за понимание сцены,

- одна же — за планирование поведения.

Это снижает сложность системы, облегчает перенос на новые платформы (другие роботы, новые типы машин) и сокращает «зоопарк» специализированных моделей в продакшне.

- Более богатый «опыт мира» = потенциально более безопасное поведение.

Благодаря объединённому обучению MiMo-Embodied видит разнообразнейшие ситуации: от коридора с коробками до перекрёстка с пешеходами; из этого может родиться более устойчивое понимание физических закономерностей (где скользко, где кто-то перекроет путь, как меняется обзор и т.д.).

Это важно для безопасности: чем больше модель «понимает мир» вне узкого домена, тем лучше она должна реагировать на редкие, нестандартные ситуации. - Одновременно — рост требований к тестированию и безопасности.

Обратная сторона: одна и та же модель может управлять разными типами критичных объектов — автомобилем на 120 км/ч и, скажем, складским роботом рядом с людьми. Ошибка ИИ мгновенно проявляется в физическом мире.

Это означает:- необходимость жёсткой сертификации, симуляций, формальных тестов и стресс-сценариев для каждого домена;

- развитие методов проверки устойчивости VLM к adversarial-атакам, промпт-инъекциям и некорректным данным датчиков;

- юридические и этические вопросы распределения ответственности между разработчиком модели, производителем устройства и оператором.

- Серьёзная заявка на открытый стандарт в «воплощённом ИИ».

MiMo-Embodied — открытая модель от крупного индустриального игрока, а не от академического консорциума. Это может:- создать де-факто стандарт для исследований и сравнений в embodied-ИИ и автономном вождении;

- дать другим компаниям и университетам мощную базу, на которой можно строить собственные системы (включая проекты по линии университетов, госпрограмм и т.п.);

- усилить конкуренцию с закрытыми стекми автопроизводителей и Big Tech, что в долгосрочной перспективе хорошо для прозрачности и безопасности.

- Геополитический и рыночный контекст.

На фоне конкуренции США–Китай в области ИИ и электроники открытие такой модели китайской компанией:- демонстрирует технологическую зрелость китайской школы embodied-ИИ и автономного вождения;

- повышает привлекательность Xiaomi как технологического партнёра для автопроизводителей и робототехнических компаний в Азии, Европе и РФ;

- создаёт для других игроков (включая европейских и российских) ориентир по уровню открытости: к чему стоит стремиться, если вы хотите не только догонять, но и влиять на развитие области.

Источники (прямые ссылки)

- arXiv (техотчёт Xiaomi):

https://arxiv.org/abs/2511.16518 (arXiv) - Hugging Face (открытая модель MiMo-Embodied-7B):

https://huggingface.co/XiaomiMiMo/MiMo-Embodied-7B (huggingface.co) - GitHub Xiaomi MiMo-Embodied (код и веса):

https://github.com/XiaomiMiMo/MiMo-Embodied (GitHub) - Обзор на goodtech.info (французский разбор результатов на 29 бенчмарках):

https://goodtech.info/xiaomi-mimo-embodied-ia-open-source-robots-voitures/ (Goodtech) - Новостные обзоры (выборочно):

• SCMP: https://www.scmp.com/tech/big-tech/article/3333787/xiaomi-open-sources-ai-model-spanning-autonomous-driving-and-robotics (scmp.com)

• AIbase / AINews: https://news.aibase.com/news/23013 (news.aibase.com)

• EEWorld / QbitAI: https://en.eeworld.com.cn/mp/QbitAI/a411621.jspx (en.eeworld.com.cn)