Безопасность искусственного интеллекта является ключевым компонентом корпоративной кибербезопасности, которая направлена на защиту инфраструктуры искусственного интеллекта от кибератак. Сосредоточение внимания на безопасности искусственного интеллекта жизненно важно, поскольку многочисленные технологии искусственного интеллекта вплетены в структуру организаций. Искусственный интеллект — это двигатель современных процессов разработки, автоматизации рабочей нагрузки и анализа больших данных. Он также все чаще становится неотъемлемым компонентом многих продуктов и услуг. Например, банковское приложение предоставляет финансовые услуги, но технологии на базе искусственного интеллекта, такие как чат-боты и виртуальные помощники в этих приложениях, обеспечивают дополнительный фактор.

По прогнозам, глобальный рынок инфраструктуры искусственного интеллекта достигнет более 96 миллиардов долларов к 2027 году. По данным McKinsey, с 2017 по 2022 год количество внедрений искусственного интеллектавыросло на 250%, и наиболее распространенные варианты использования включали оптимизацию сервисных операций, создание новых продуктов на основе искусственного интеллекта, аналитику обслуживания клиентов и сегментацию клиентов. К сожалению, каждый из этих вариантов использования искусственного интеллекта подвержен кибератакам и другим уязвимостям.

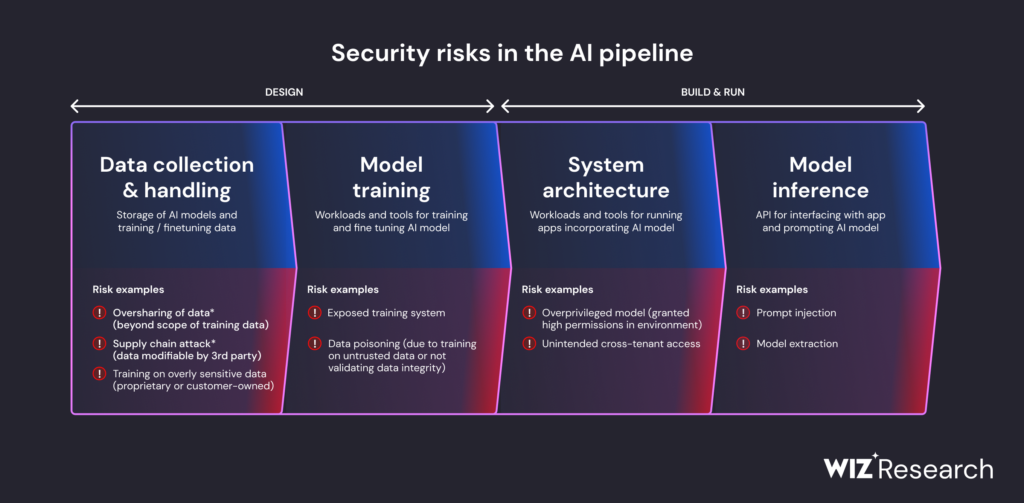

Это только верхушка айсберга. Инженеры по обработке данных и другие гибкие команды используют решения GenAI, такие как большие языковые модели (LLM), для быстрой и масштабируемой разработки приложений. Многие поставщики облачных услуг (CSP) предлагают услуги искусственного интеллекта для поддержки этой разработки. Возможно, вы слышали или использовали такие сервисы искусственного интеллекта, как Azure Cognitive Services, Amazon Bedrock и Vertex AI от GCP. Хотя такие сервисы и технологии позволяют командам быстрее разрабатывать и развертывать приложения ИИ, эти конвейеры сопряжены с многочисленными рисками. Суть в том, что ИИ не так безопасен, как многие считают, и требует надежных укреплений.

Насколько (не) безопасен искусственный интеллект?

Повествование, связанное с ИИ, часто фокусируется на этике и возможности того, что ИИ заменит человеческую рабочую силу. Однако Forrester утверждает, что 11 миллионов рабочих мест в США, которые будут заменены искусственным интеллектом к 2032 году, будут уравновешены другими новыми возможностями трудоустройства. Относительно недооцененная сложность находится на стыке искусственного интеллекта и кибербезопасности. Субъекты угроз используют искусственный интеллект для распространения вредоносных программ и заражения кода и наборов данных. Уязвимости искусственного интеллекта являются распространенным источником утечек данных, а жизненные циклы разработки программного обеспечения (SDLC), включающие искусственный интеллект, становятся все более подверженными уязвимостям.

GenAI, в частности, представляет множество рисков. Опасный потенциал GenAI проявляется в инструментах, таких как WormGPT, которые похожи на ChatGPT, но с акцентом на ведение преступной деятельности. К счастью, применение искусственного интеллекта в кибербезопасности используется для отражения таких угроз. Рынок искусственного интеллекта на рынке кибербезопасности достигнет 60,6 миллиарда долларов к 2028 году, что доказывает, что группам безопасности будет сложно выявлять и устранять крупномасштабные кибератаки, осуществляемые с помощью искусственного интеллекта, без использования самого искусственного интеллекта.

Кибербезопасность Искусственный интеллект продолжит играть большую роль в борьбе с угрозами безопасности на базе искусственного интеллекта. Это важно, потому что субъекты угроз будут использовать подсказки LLM в качестве вектора для манипулирования моделями GenAI с целью раскрытия конфиденциальной информации. CSP, вероятно, скоро полностью примут революцию в области искусственного интеллекта, а это значит, что важные решения, связанные с инфраструктурой и развитием, будут приниматься чат-ботами с искусственным интеллектом. Использование чат-ботов в качестве оружия (таких как WormGPT или FraudGPT) предполагает, что компаниям придется считаться с множеством непредсказуемых проблем кибербезопасности, связанных с искусственным интеллектом.

Важно помнить, что искусственный интеллект может быть защищен. Однако по своей сути он небезопасен.

Риски безопасности искусственного интеллекта

Лучший способ решить проблему безопасности искусственного интеллекта — это досконально понять риски. Давайте рассмотрим самые большие риски для безопасности искусственного интеллекта.

Увеличена поверхность атаки

Интеграция искусственного интеллекта, такого как GenAI, в SDLC фундаментально меняет ИТ-инфраструктуру предприятия и привносит множество неизвестных рисков. По сути, это расширение области атаки. Главная задача безопасности искусственного интеллекта заключается в обеспечении того, чтобы вся инфраструктура искусственного интеллекта находилась под управлением групп безопасности. Полная прозрачность инфраструктуры искусственного интеллекта может помочь устранить уязвимости, снизить риски и ограничить поверхность атаки.

Повышенная вероятность утечек данных

The Independent Согласно, риски более широкого охвата атаками включают простои, сбои, потери прибыли, ущерб репутации и другие серьезные долгосрочные последствия. Только за август 2023 года было скомпрометировано 43 миллиона конфиденциальных записей. Неоптимальная безопасность искусственного интеллекта может поставить под угрозу ваши драгоценности короны и внести вас в списки жертв утечки данных.

Кража учетных данных чат-бот

Украденные учетные данные ChatGPT и других чат-ботов стали новым популярным товаром на нелегальных рынках в темной паутине. Более 100 000 учетных записей ChatGPT были скомпрометированы в период с 2022 по 2023 год, что подчеркивает опасный риск безопасности искусственного интеллекта, который, вероятно, возрастет.

Уязвимые конвейеры разработки

Конвейеры искусственного интеллекта имеют тенденцию расширять спектр уязвимостей. Например, область науки о данных, охватывающая разработку данных и моделей, часто выходит за рамки традиционной разработки приложений, что приводит к новым рискам безопасности.

Процесс сбора, обработки и хранения данных является фундаментальным в области разработки машинного обучения. Интеграция с задачами разработки моделей требует надежных протоколов безопасности для защиты данных от взломов, кражи интеллектуальной собственности, атак на цепочки поставок, а также манипулирования данными или отравления. Обеспечение целостности данных имеет решающее значение для уменьшения как преднамеренных, так и случайных расхождений в данных.

Отравление данными

Отравление данными — это манипулирование моделями GenAI. Оно включает в себя ввод вредоносных наборов данных для влияния на результаты и создания предвзятостей. Trojan Puzzle, атака, разработанная исследователями, является примером того, как субъекты угрозы могут влиять на наборы данных, на основе которых модель GenAI обучается управлению вредоносными полезными нагрузками, и заражать их.

Прямые инъекции подсказок

Прямые инъекции подсказок — это тип атаки, при котором субъекты угрозы намеренно разрабатывают подсказки LLM, намереваясь скомпрометировать или отфильтровать конфиденциальные данные. Существует множество рисков, связанных с прямым оперативным внедрением, включая выполнение вредоносного кода и раскрытие конфиденциальных данных.

Косвенные подсказки

Косвенное внедрение запроса — это когда субъект угрозы направляет модель GenAI к ненадежному источнику данных, чтобы влиять на его действия и манипулировать ими. Этот внешний ненадежный источник может быть специально разработан субъектами угроз для преднамеренного побуждения к определенным действиям и влияния на полезные нагрузки. Последствия косвенного внедрения подсказок включают выполнение вредоносного кода, утечки данных и предоставление конечным пользователям дезинформации и вредоносной информации.

Злоупотребление галлюцинациями

Искусственный интеллект всегда был склонен к галлюцинации определенной информацией, и новаторы по всему миру работают над уменьшением масштабов галлюцинации. Но пока они этого не сделают, галлюцинации искусственного интеллекта продолжают представлять значительные риски для кибербезопасности. Субъекты угроз начинают регистрировать и «узаконивать» потенциальные галлюцинации искусственного интеллекта, чтобы конечные пользователи получали информацию, на которую влияют вредоносные и нелегитимные наборы данных.

Основы и стандарты безопасности искусственного интеллекта

Теперь, когда вы знаете о самых больших рисках безопасности искусственного интеллекта, давайте кратко рассмотрим, как предприятия могут их снизить. Системы кибербезопасности уже давно являются мощным инструментом защиты предприятий от растущих угроз, и эти системы безопасности искусственного интеллекта обеспечивают согласованный набор стандартов и передовых практик для устранения угроз безопасности и уязвимостей:

- Система управления рисками в области NIST разбивает безопасность искусственного интеллекта на четыре основные функции: управление, отображение, измерение и менеджмент.

- Матрица ATLAS и разумная нормативная база для обеспечения безопасности искусственного интеллектаMitre анатомируют тактику атак и предлагают определенные правила для искусственного интеллекта.

- Top 10 для LLMOWASP определяет и предлагает стандарты для защиты наиболее критичных уязвимостей, связанных с LLM, таких как оперативные инъекции, уязвимости цепочки поставок и кража модели.

- Платформа Secure AIGoogle предлагает шестиступенчатый процесс для смягчения проблем, связанных с системами искусственного интеллекта. К ним относятся автоматизированные укрепления кибербезопасности и управление на основе рисков.

- В собственнойPEACH Framework делается упор на изоляцию клиентов с помощью усиления привилегий, шифрования, аутентификации, подключения и гигиены (P.E.A.C.H.). Изоляция клиентов — это принцип проектирования, который разбивает ваши облачные среды на отдельные сегменты с жесткими границами и строгим контролем доступа.

Несколько простых рекомендаций по безопасности искусственного интеллекта и лучшие практики

Ключом к защите вашей инфраструктуры искусственного интеллекта является разработка и следование набору лучших практик. Вот 10 наших собственных, которые помогут вам начать:

1. Выберите платформу изоляции арендатора

Платформа изоляции арендаторов PEACH была разработана для облачных приложений, но те же принципы применимы и к безопасности искусственного интеллекта. Изоляция арендаторов — мощный способ борьбы со сложностями интеграции GenAI.

2. Настройте свою архитектуру GenAI

Ваша архитектура GenAI должна быть тщательно настроена, чтобы гарантировать, что все компоненты имеют оптимизированные границы безопасности. Некоторым компонентам могут потребоваться общие границы безопасности, другим — выделенные границы, а для некоторых это может зависеть от различных контекстов.

3. Оцените контуры и сложности GenAI

Необходимо проанализировать последствия интеграции GenAI в продукты, услуги и процессы вашей организации. Некоторые важные соображения заключаются в том, что ответы ваших моделей искусственного интеллекта конечным пользователям являются конфиденциальными, точными и построены на основе законных наборов данных.

4. Не пренебрегайте традиционными уязвимостями, не зависящими от облака

Помните, что GenAI ничем не отличается от других мультитенантных приложений. Он по-прежнему может страдать от традиционных проблем, таких как уязвимости API и утечки данных. Убедитесь, что ваша организация не пренебрегает всеобъемлющими уязвимостями в облаке в своем стремлении смягчить проблемы, связанные с ИИ.

5. Обеспечьте эффективную «песочницу»

Изолированная обработка включает в себя перенос приложений, включающих GenAI, в изолированные тестовые среды и помещение их под сканер, и это эффективный метод устранения уязвимостей ИИ. Однако убедитесь, что ваши среды изолированной обработки оптимально настроены. Неоптимальные изолированные среды и процессы, созданные в спешке, могут усугубить уязвимости в системе безопасности искусственного интеллекта.

6. Проводите проверки изоляции

Обзор изоляции арендатора предоставляет исчерпывающую топологию интерфейсов, ориентированных на клиента, и внутренних границ безопасности. Это может помочь выявить уязвимости в системе безопасности искусственного интеллекта и дополнительно оптимизировать изоляцию арендатора для предотвращения инцидентов кибербезопасности.

7. Расставьте приоритеты в очистке входных данных

Установите определенные ограничения на ввод данных пользователем в системах GenAI для устранения уязвимостей в системе безопасности искусственного интеллекта. Эти ограничения не обязательно должны быть сверхсложными. Например, вы можете заменить текстовые поля выпадающими меню с ограниченными возможностями ввода. Самой большой проблемой при очистке входных данных будет нахождение баланса между надежной безопасностью и плавным взаимодействием с конечным пользователем.

8. Оптимизируйте оперативную обработку

Обработка запросов жизненно важна в приложениях, использующих GenAI. Компаниям необходимо отслеживать и регистрировать запросы конечных пользователей и отмечать красным флажком любые запросы, которые кажутся подозрительными. Например, если в приглашении отображаются какие-либо признаки выполнения вредоносного кода, оно должно быть помечено красным флажком и устранено.

9. Поймите последствия отзывов клиентов для безопасности

Это может рассматриваться как проблема безопасности искусственного интеллекта с относительно низким уровнем риска, но в вашей стратегии и методах обеспечения безопасности искусственного интеллекта не должно быть никаких трещин. Дело в том, что текстовое поле обратной связи может позволить субъектам угрозы внедрять вредоносный контент в приложение, включающее GenAI. Простой наилучшей практикой является замена вариантов обратной связи с произвольным текстом раскрывающимися полями.

10. Работайте с авторитетными экспертами по безопасности искусственного интеллекта

Искусственный интеллект займет центральное место в следующей главе технического прогресса. Вот почему безопасность искусственного интеллекта имеет решающее значение и не может рассматриваться как второстепенная мысль. Работа с авторитетными и высококвалифицированными экспертами по облачной безопасности — лучший способ укрепить ваш уровень искусственного интеллекта и кибербезопасности.

Защита искусственного интеллекта с помощью Wiz

Wiz — первое CNAPP, предлагающее собственные возможности безопасности искусственного интеллекта, полностью интегрированные в платформу. Wiz для обеспечения безопасности искусственного интеллекта представляет следующие новые возможности:

- Управление состоянием безопасности искусственного интеллекта (AI-SPM): предоставляет командам безопасности и разработчикам искусственного интеллекта доступ к их конвейерам искусственного интеллекта путем идентификации каждого ресурса и технологии в конвейере искусственного интеллекта без каких-либо агентов

- Расширение DSPM для ИИ: автоматически обнаруживает конфиденциальные данные обучения и помогает вам обеспечить их безопасность благодаря новым готовым элементам управления ИИ DSPM

- Расширение анализа путей атаки на искусственный интеллект: полный контекст облака и рабочей нагрузки вокруг конвейера искусственного интеллекта, помогающий организациям активно устранять пути атаки в среде

- Панель мониторинга безопасности искусственного интеллекта: предоставляет обзор основных проблем безопасности искусственного интеллекта с приоритетной очередью рисков, чтобы разработчики могли быстро сосредоточиться на наиболее важных