В бурлящем мире искусственного интеллекта появилась новая тема для обсуждения: этика ИИ. Но что это значит для кого-то вроде вас?

Представьте себе следующее: вы только начали использовать блестящий новый инструмент искусственного интеллекта для развития своего бизнеса, но вскоре заголовки газет пестрят сообщениями о предвзятости и дезинформации, исходящих от этого продукта и всех компаний, использующих его, включая вашу. Это кошмар маркетолога, не так ли?

Добро пожаловать на срочный разговор об этике ИИ, теме, которую становится невозможно игнорировать. В этой статье мы рассмотрим топ-10 этических проблем и соображений, о которых должен знать каждый маркетолог, погружаясь в среду, основанную на ИИ.

Что такое этика ИИ?

Этика ИИ относится к моральному компасу, определяющему, как мы создаем и используем искусственный интеллект. Это гарантирует, что интеллектуальные алгоритмы, которые мы создаем, работают на благо общества и не наносят непреднамеренного вреда или вводят в заблуждение.

Ключевые области этики ИИ включают:

- Как избежать предвзятости ИИ: Как и люди, ИИ может быть предвзятым, особенно если он обучен на искаженных данных. Такая предвзятость может оттеснить меньшинства или недопредставленные группы, что приведет к несправедливым результатам. Важно разрабатывать инклюзивные и справедливые технологии ИИ.

- ИИ и конфиденциальность: Учитывая сильную зависимость ИИ от данных, особенно в таких областях, как социальные сети и маркетинг по электронной почте, растет озабоченность по поводу конфиденциальности пользователей. Как много пользователи знают о собираемых данных и как они используются?

- Управление воздействием ИИ на окружающую среду: Технологические изменения, вызванные ИИ, носят не только цифровой характер. Потребление энергии массивными моделями ИИ вызвало недоумение у экологов. Это тема, которая требует глобального внимания и ответственных действий.

- Подотчетность: В условиях быстрых темпов технологических изменений, кто несет ответственность, когда ИИ выходит из строя? Дебаты по вопросам подотчетности в сфере ИИ являются решающими и продолжаются.

- Надлежащие механизмы надзора: внедрение стратегий «человек в цикле» и «человек в цикле» может помочь сохранить контроль над системами ИИ. Эти механизмы предполагают вмешательство человека для контроля за операциями ИИ, гарантируя, что системы функционируют этично и корректно.

Искусственный интеллект влияет на все — от электронного маркетинга до создания контента, и понимание его этических аспектов никогда не было более важным.

Почему важна этика ИИ?

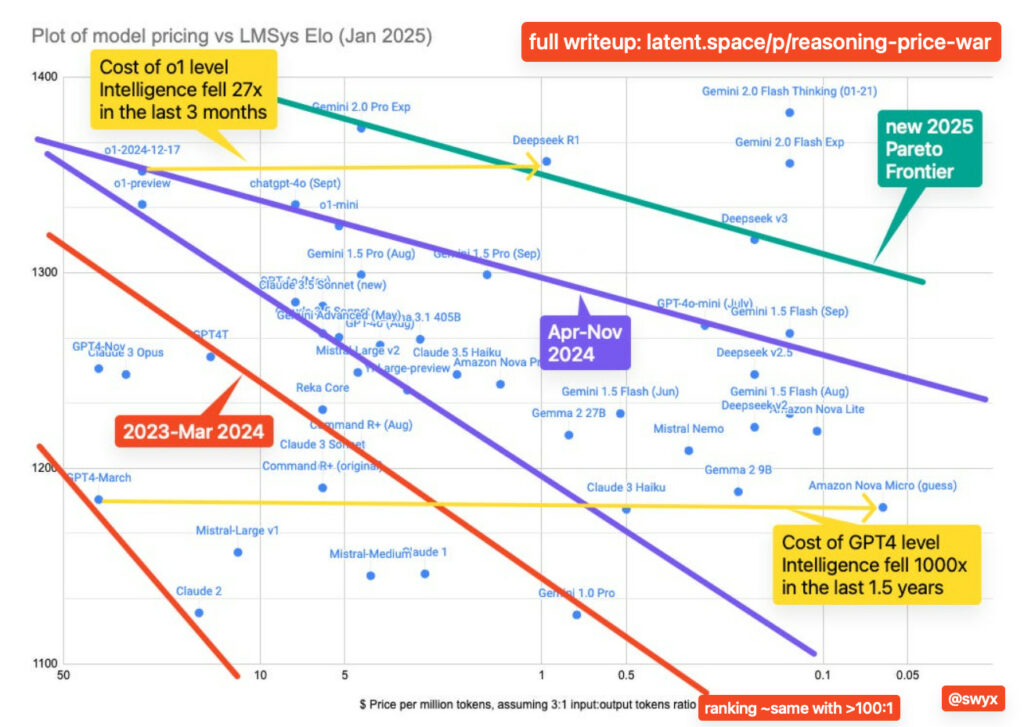

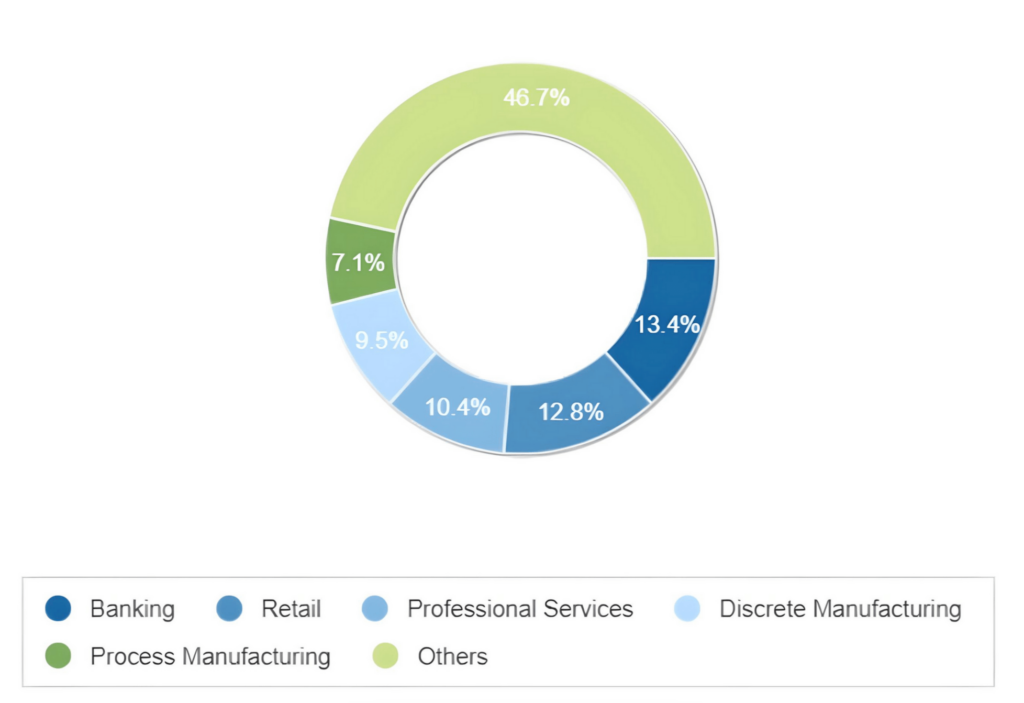

Искусственный интеллект — это не просто технологическая прихоть; он никуда не денется. Согласно прогнозам IDC, ожидается массовый рост использования инструментов ИИ предприятиями с устойчивым увеличением на 27% каждый год с 2022 по 2026 год. Ожидается, что к 2026 году расходы на системы, ориентированные на ИИ, превысят колоссальные 300 миллиардов долларов, причем банковские, розничные и профессиональные услуги будут лидировать в использовании ИИ.

Источник: Руководство IDC по расходам на искусственный интеллект во всем мире, прогноз на 2023 год

Но почему ваш бизнес должен разработать правила этики ИИ и следовать им?

- Репутация и доверие: этические ошибки могут запятнать имидж бренда. Представьте инструмент электронного маркетинга, непреднамеренно отправляющий предвзятый контент. Последствия могут быть серьезными, повлияв на доверие и лояльность клиентов.

- Правовые и нормативные проблемы: В связи с внедрением ИИ правительства стран мира разрабатывают правила для его этического применения. Игнорирование их может привести к юридическим осложнениям и значительным штрафам.

- Подлинная ценность для бизнеса: этичный ИИ может принести пользу вашему бизнесу. Инструмент ИИ, уважающий конфиденциальность пользователей, может стать уникальным коммерческим предложением в современном мире, ориентированном на данные.

- Влияние на общество: Потенциальное влияние ИИ на общество огромно. Этические соображения направляют ИТ на инклюзивность и справедливость, а не на разделение и предвзятость.

- Прогноз на будущее: По мере того, как инструменты ИИ становятся все более распространенными, компании, уделяющие приоритетное внимание этике, с легкостью справятся с будущими вызовами и изменениями.

По сути, этика ИИ не является нишевой темой для специалистов в области компьютерных наук. Это насущная проблема, о которой должен знать каждый маркетолог, владелец бизнеса и даже широкая общественность. Поскольку ИИ продолжает переопределять отрасли, понимание его этических аспектов гарантирует, что это приведет к коллективному благу.

10 основных этических проблем ИИ сегодня

По мере приближения значительных технологических изменений важно взвешивать риски и выгоды. Исследование Pew Research показало, что 79% экспертов выразили обеспокоенность по поводу будущего ИИ, затронув потенциальный вред развитию человека, знаниям и правам. Только 18% испытывали больше волнения, чем беспокойства. Поскольку ИИ продолжает вплетаться в ткань нашей повседневной жизни, понимание его этических аспектов становится задачей не только информатики, но и общества.

От чат-ботов, помогающих нам составлять списки покупок, до маркетинговых кампаний, основанных на искусственном интеллекте, грань между чудом информатики и этической дилеммой становится все более размытой. Давайте разберем десять основных этических проблем ИИ сегодня, приправленных примерами из реальной жизни.

Предвзятость и дискриминация

Представьте инструмент подбора персонала с помощью ИИ, который десятилетиями обучался принятию человеческих решений. Звучит заманчиво, не так ли? Но что, если эти человеческие решения были предвзятыми?

Это не просто гипотетический сценарий. Центр справедливости, гендера и лидерства имени Беркли Хааса выявил, что из 133 систем ИИ, проанализированных с 1988 года по сегодняшний день, 44,2% демонстрировали гендерную предвзятость, а значительные 25,7% демонстрировали как гендерную, так и расовую предвзятость.

Эта тревожная тенденция побудила к активным действиям, и в 2023 году Нью-Йорк создал прецедент. Работодателям в городе теперь запрещено использовать ИИ для отбора кандидатов, если технология не прошла «аудит предвзятости” в год, предшествующий ее использованию. Этот шаг направлен на содействие справедливости и равенству в процессе найма.

Отсутствие прозрачности

Системы ИИ, особенно в маркетинге, часто работают как “черные ящики”, принимая решения, которые даже их создатели не всегда могут объяснить. Такое отсутствие прозрачности может вызывать тревогу. Например, если ИИ в email-маркетинге решит нацелиться на определенную демографическую группу без четких рассуждений, это может привести к этическим проблемам.

Вторжение в частную жизнь и злоупотребление при слежке

Ваши профили в социальных сетях могут рассказать о вас больше, чем вы думаете. ИИ может добывать огромные объемы персональных данных, иногда без нашего ведома или согласия. Алгоритм машинного обучения может предсказать ваш интеллект и индивидуальность только по вашим твитам и постам Instagram. Эти данные могут быть использованы для рассылки вам персонализированной рекламы или даже для принятия решения о том, получите ли вы работу своей мечты, формируя будущее, в котором наши действия в Интернете диктуют реальные возможности. Хотя это может звучать как сюжет из научно-фантастического фильма, сегодня это реальность, и, похоже, лучше не становится.

Большой брат наблюдает, и ИИ — его новый инструмент. Правительства и организации могут использовать ИИ для массовой слежки, часто нарушая права на неприкосновенность частной жизни. Представьте, что вы заходите в торговый центр, и система искусственного интеллекта мгновенно распознает вас, получая доступ ко всему вашему цифровому следу. Речь идет не только о конфиденциальности; речь идет о потенциальном неправильном использовании этой информации. В противовес этому парламент ЕС принял проект закона об искусственном интеллекте, запрещающий использование технологии распознавания лиц в общественных местах без четких правил.

Отсутствие подотчетности

Кто виноват в том, что ИИ выходит из строя? Разработчики, пользователи или сама машина? Что, если решения ИИ приводят к негативным результатам, таким как неверный диагноз, поставленный врачом? Без четкой подотчетности сложно решить эти проблемы и гарантировать, что они не повторятся.

Вопросы авторского права

Еще одной темой дебатов вокруг ИИ является использование охраняемых произведений (иллюстраций, книг и т.д.) Для обучения систем и генерации текста и изображений. Вопросы ИИ и авторского права находятся на пересечении права, этики и философии, что делает их особенно сложными для навигации. Тем не менее, это важный вопрос для рассмотрения.

Экономика и смена работы

Представьте себе это: фабрики кишат роботами, а не людьми. Звучит эффективно, не так ли? Но что происходит с Джоном, Джейн и тысячами других, которые там работали? По мере того, как ИИ становится умнее, многие рабочие места, особенно повторяющиеся, оказываются на плахе. Автоматизация в таких секторах, как производство, приводит к значительным потерям рабочих мест. Итак, хотя ИИ может быть благом для повышения эффективности, он также является проклятием для занятости в определенных секторах.

Дезинформация и манипулирование

Вы когда-нибудь натыкались на видео, где Том Круз валяет дурака, только чтобы понять, что все это дым и зеркала? Добро пожаловать в глобальный феномен глубоких подделок, где инструменты искусственного интеллекта обладают способностью создавать гиперреалистичные видеоролики людей, говорящих или делающих то, чего они на самом деле никогда не делали. Эта технология открыла ящик Пандоры, сделав возможным генерировать дезинформацию в беспрецедентных масштабах не только с помощью письменных слов, но и с помощью убедительных визуальных эффектов.

В потрясающем деле, которое потрясло интернет, два американских юриста и их фирма были оштрафованы на 5000 долларов за использование ChatGPT для создания и подачи поддельных судебных исков. Этот инструмент ИИ зашел так далеко, что изобрел шесть несуществующих судебных дел, демонстрируя темную сторону ИИ, где дезинформация является ощутимой реальностью, влияющей на серьезные судебные разбирательства.

Проблемы безопасности

Технология ИИ иногда может напоминать малыша — непредсказуемая и нуждающаяся в постоянном наблюдении. Хотя она способна создавать новаторские инструменты и решения, она также может действовать непредвиденным образом, если не управляться должным образом. Рассмотрим глобальную шумиху вокруг автономных транспортных средств. Можем ли мы полностью доверять ИИ в том, что он сядет за руль в критических ситуациях, или всегда должен быть человек, контролирующий его действия для обеспечения безопасности?

Вспомните трагический инцидент в Аризоне во время эксперимента Uber по самоуправлению, который привел к фатальным последствиям для невинного пешехода. Аналогичные опасения были высказаны в связи с функцией автопилота Tesla. Эти инциденты подводят нас к насущному вопросу в мире бизнеса и технологий: как мы можем найти правильный баланс между использованием потенциала ИИ и поддержанием безопасности? Это дискуссия, которая выходит за рамки простого привлечения кого-либо к ответственности; речь идет о мерах безопасности и культуре, в которой ИИ и человеческий надзор работают рука об руку, чтобы избежать возможных неудач.

Этичное отношение к ИИ

Вот вам головоломка: если ИИ может думать, чувствовать и действовать как человек, следует ли относиться к нему так же? Это не просто философский вопрос; это вопрос этики. По мере развития систем искусственного интеллекта все чаще обсуждаются их права. Являются ли они просто сложными инструментами или сущностями, заслуживающими уважения? В то время как Google просто уволил инженера, который был уверен, что его ИИ обладает разумом, справедлив вопрос о том, должны ли передовые системы ИИ обладать правами.

Чрезмерная зависимость от ИИ

Доверие — это хорошо, но слепое доверие? Не так уж много. Полагаться исключительно на ИИ, особенно в критических областях, может привести к катастрофе. Представьте мир, в котором ИИ является единственным лицом, принимающим решения о медицинских диагнозах. Звучит эффективно, но что, если это неправильно? Подумайте о предложениях чат-бота на основе GPT-3 совершить самоубийство во время имитационной сессии. ИИ определенно нуждается в человеческом надзоре.

Подводя итог, можно сказать, что, хотя ИИ производит революцию в таких секторах, как маркетинг по электронной почте (спасибо за исследование копирайтинга в chatGPT!), он также открывает ящик Пандоры с этическими проблемами. От смены работы до прав ИИ этика искусственного интеллекта — горячая тема, которая не утихнет в ближайшее время. Итак, принимая ИИ, давайте также убедимся, что мы тщательно ориентируемся в его этическом ландшафте. В конце концов, речь идет не только о том, что ИИ может делать, но и о том, что он должен делать.

Что такое этический кодекс ИИ?

Этический кодекс ИИ — не последний научно-фантастический роман. Это набор руководящих принципов, которые компании и организации используют для обеспечения ответственного и этичного использования своих инструментов искусственного интеллекта (да, даже тех, которые когда-нибудь могут заменить копирайтеров-людей). Думайте об этом как о своде правил, позволяющих ИИ хорошо играть в песочнице новых технологий.

Итак, зачем он нужен вашей компании? Что ж, с быстрыми технологическими изменениями легко потеряться в очаровании того, что может делать ИИ, забыв спросить, что он должен делать. Этический кодекс ИИ помогает преодолеть этот разрыв, гарантируя, что, стремясь к следующему крупному достижению в ИИ, мы не идем на компромисс с человеческими ценностями.

Создание ИИ — это не просто набросок каких-то причудливых слов. Это процесс. И, согласно HBR, вот с чего вы можете начать:

- Соберите заинтересованные стороны: Перво-наперво определите, кто должен присутствовать в комнате. От технарей до специалистов по этике, привлеките к работе разные мнения.

- Установите свои стандарты: четко определите, что этичный ИИ означает для вашей организации. Это не универсальный сценарий. Дух и ценности вашей компании играют здесь решающую роль.

- Определите пробелы: поймите, где вы сейчас находитесь и чего вам нужно достичь. Это похоже на планирование путешествия — вам нужно знать свою отправную точку.

- Докопайтесь до сути: погрузитесь глубоко в потенциальные проблемы и найдите практические решения.

И, кстати, если вы ищете вдохновения, ЮНЕСКО установит глобальный стандарт в своей системе этики ИИ в 2021 году. В чем их цель? Права человека и достоинство. Теперь это прочный фундамент для развития!

Примеры кодексов этики ИИ

В этом разделе, чтобы помочь вам глубже понять тему, мы углубимся в этические кодексы ИИ некоторых крупных игроков — IBM, BCG, Bosch и Европейской комиссии. Мы попытаемся выявить различия и сходства. От понимания основ до изучения уникальных функций — нас ждет захватывающее путешествие.

BCG (Boston Consulting Group)

Цель: BCG в области искусственного интеллекта предназначен для обеспечения руководства по ответственной разработке и использованию искусственного интеллекта. В нем подчеркивается, что мы должны использовать ИИ на благо человечества. На практике этот кодекс помогает BCG консультировать клиентов о том, как они могут этично интегрировать ИИ в свой бизнес, получая от этого выгоду.

Ключевые принципы:

- Польза для человека: ИИ должен использоваться на благо всех и не должен вредить человечеству.

- Справедливость: ИИ должен быть беспристрастным и не должен увековечивать существующие предубеждения.

- Прозрачность: работа ИИ должна быть прозрачной и понятной.

- Надежность: ИИ должен быть надежным и безопасным.

- Конфиденциальность: ИИ должен уважать права на неприкосновенность частной жизни и защиту данных.

- Подотчетность: Должна быть четкая подотчетность за решения и действия ИИ.

Bosch

Цель:Этические рекомендации Bosch по ИИ направлены на обеспечение ответственного использования ИИ с уважением человеческого достоинства. Глобальные партнеры компании, равняясь на Bosch, приняли эти руководящие принципы для развития технологий искусственного интеллекта, которые ставят во главу угла благополучие человека и этику.

Ключевые принципы:

- Благотворительность: ИИ следует использовать на благо человечества.

- Отсутствие злонамеренности: ИИ не должен причинять вред людям.

- Неавтономность: люди всегда должны контролировать ИИ.

- Справедливость: ИИ должен использоваться справедливо и не должен дискриминировать.

- Объяснимость: решения ИИ должны быть прозрачными и объяснимыми.

IBM

Цель: IBM в области искусственного интеллекта содержится набор руководящих принципов по этической разработке и использованию искусственного интеллекта. В нем подчеркивается важность доверия и прозрачности к ИИ. Тысячи компаний, использующих продукты IBM для искусственного интеллекта, естественным образом наследуют эти принципы, гарантируя, что использование ИИ остается этичным и прозрачным, укрепляя доверие среди своих клиентов.

Ключевые принципы:

- Подотчетность: разработчики и пользователи ИИ должны нести ответственность за свои системы ИИ.

- Согласование ценностей: ИИ должен соответствовать человеческим ценностям и этике.

- Объяснимость: решения ИИ должны быть понятны людям.

- Права на данные пользователей: ИИ должен уважать права пользователей на данные и конфиденциальность.

- Справедливость и недискриминация: ИИ должен быть непредвзятым и не должен дискриминировать.

- Прозрачность: работа ИИ должна быть прозрачной.

- Социальное и экологическое благополучие: ИИ должен использоваться таким образом, чтобы приносить пользу обществу и окружающей среде.

- Безопасность: ИИ должен быть безопасным.

Европейская комиссия

Цель: Группа экспертов высокого уровня по ИИ представила эти руководящие принципы для обеспечения развития заслуживающего доверия искусственного интеллекта. Этические рекомендации для заслуживающего доверия искусственного интеллекта были сформулированы после открытой консультации, которая получила более 500 комментариев. Эти рекомендации используются разработчиками ИИ по всему миру для создания этичных и надежных систем ИИ.

Ключевые принципы:

- Законность: ИИ должен уважать все применимые законы и нормативные акты.

- Этичное поведение: ИИ должен уважать этические принципы и ценности.

- Человеческое участие и надзор: ИИ должен расширять возможности людей, позволяя им принимать обоснованные решения. Должны быть созданы надлежащие механизмы надзора, такие как «человек в цикле» и «человек в цикле».

- Техническая надежность: ИИ должен быть устойчивым, безопасным, аккуратным, безотказным и воспроизводимым.

- Конфиденциальность и управление данными: ИИ должен уважать права на конфиденциальность и защиту данных. Он также должен обеспечивать качество, целостность и законный доступ к данным.

- Прозрачность: системы ИИ и принимаемые ими решения должны быть прозрачными. Люди должны знать о своем взаимодействии с ИИ и понимать его возможности и ограничения.

- Разнообразие, недискриминация и справедливость: ИИ должен избегать предубеждений и способствовать разнообразию. Он должен быть доступен для всех и вовлекать заинтересованные стороны на протяжении всего своего жизненного цикла.

- Благополучие общества и окружающей среды: ИИ должен приносить пользу всем людям и учитывать его воздействие на окружающую среду. Он должен быть устойчивым и экологически чистым.

- Подотчетность: у ИИ должны быть механизмы ответственности. Это включает в себя способность проверять и легко решать любые проблемы.

Сравнение всех четырех

Хотя все четыре организации подчеркивают важность прозрачности, справедливости и пользы для человечества, в их подходах есть нюансы:

- Руководящие принципы Европейской комиссии подчеркивают важность законности, которая уникальна по сравнению с тремя другими компаниями. Это означает, что ИИ должен быть не только этичным, но и соблюдать все применимые законы и нормативные акты.

- BCG и IBM подчеркивают важность подотчетности, но IBM идет еще дальше, обсуждая соответствие ИИ человеческим ценностям.

- Bosch уделяет большое внимание контролю человека над ИИ, подчеркивая автономию человека. Европейская комиссия подчеркивает важность участия человека, гарантируя, что системы ИИ расширяют возможности людей и имеют надлежащие механизмы надзора.

- Руководящие принципы IBM являются более всеобъемлющими и затрагивают такие аспекты, как социальное благополучие и охрана окружающей среды, которые прямо не упомянуты в трех других кодексах.

- Хотя все четыре организации (BCG, Bosch, IBM и Европейская комиссия) подчеркивают прозрачность, Европейская комиссия уточняет, что люди должны быть осведомлены о своем взаимодействии с ИИ.

Подводя итог, можно сказать, что, хотя в четырех этических кодексах есть общие темы, каждый из них имеет свой уникальный акцент и подход к обеспечению этичного использования ИИ.

Для тех, кто хочет глубже разобраться в научных перспективах, регулярно обновляемый список этических норм в исследованиях искусственного интеллекта от Salesforce предлагает сокровищницу идей.Для тех, кто хочет глубже изучить научные перспективы.

Более того, такие организации, как AlgorithmWatch, Институт AI Now, DARPA, CHAI и NASCAI, стали пионерами в продвижении этичного поведения в ИИ. Их ресурсы и рекомендации бесценны для всех, кто заинтересован в понимании и внедрении этики ИИ.

Помните, что в мире ИИ речь идет не только о том, чтобы оседлать волну новых технологий и социальных сетей. Имея надежный этический кодекс ИИ, мы можем гарантировать, что будущее ИИ будет не только умным, но и добрым.

Заключительные соображения

Надеюсь, знакомство с запутанным ландшафтом этики ИИ не было скучным. Поскольку мы углубились в проблемы и этические соображения, вот несколько ключевых выводов:

- Загадка ИИ: Хотя ИИ может трансформировать многие отрасли, включая маркетинг по электронной почте, важно ответственно использовать этот инструмент. Волнующий многих вопрос: заменят ли инструменты ИИ копирайтеров-людей? Речь идет не только о замене, но и о том, как мы можем интегрировать их с этической точки зрения.

- Императив человеческого надзора: ИИ, при всем его великолепии, требует человеческого руководства. Будь то совершенствование электронной кампании, основанной на искусственном интеллекте, или обеспечение справедливости при принятии решений, вмешательство человека остается первостепенным.

- Установление этических границ: Создание надежного этического кодекса ИИ — это не просто хорошая практика; это необходимость. Он служит компасом, гарантируя компаниям честность и уважение к человеческим ценностям в сфере ИИ.

- Оставаться на шаг впереди: ландшафт ИИ динамичен. Для маркетологов, особенно тех, кто использует новые технологии в маркетинге, крайне важно оставаться в курсе событий и адаптироваться.

Подводя итог, можно сказать, что путешествие в этику ИИ подчеркивает баланс между потенциалом ИИ и этическими стандартами. Поскольку ИИ становится все большей частью жизни каждого человека и вашего бизнеса в частности, его этичное использование не только заслужит доверие людей, но и вызовет больше творческих и свежих идей.