Введение

С ростом популярности генеративного ИИ, таких как ChatGPT и аналогичные технологии, компании сталкиваются с новыми вызовами в области информационной безопасности. Генеративные модели обладают огромным потенциалом, но также могут создавать уязвимости, связанные с утечкой данных, манипуляциями или кибератаками.

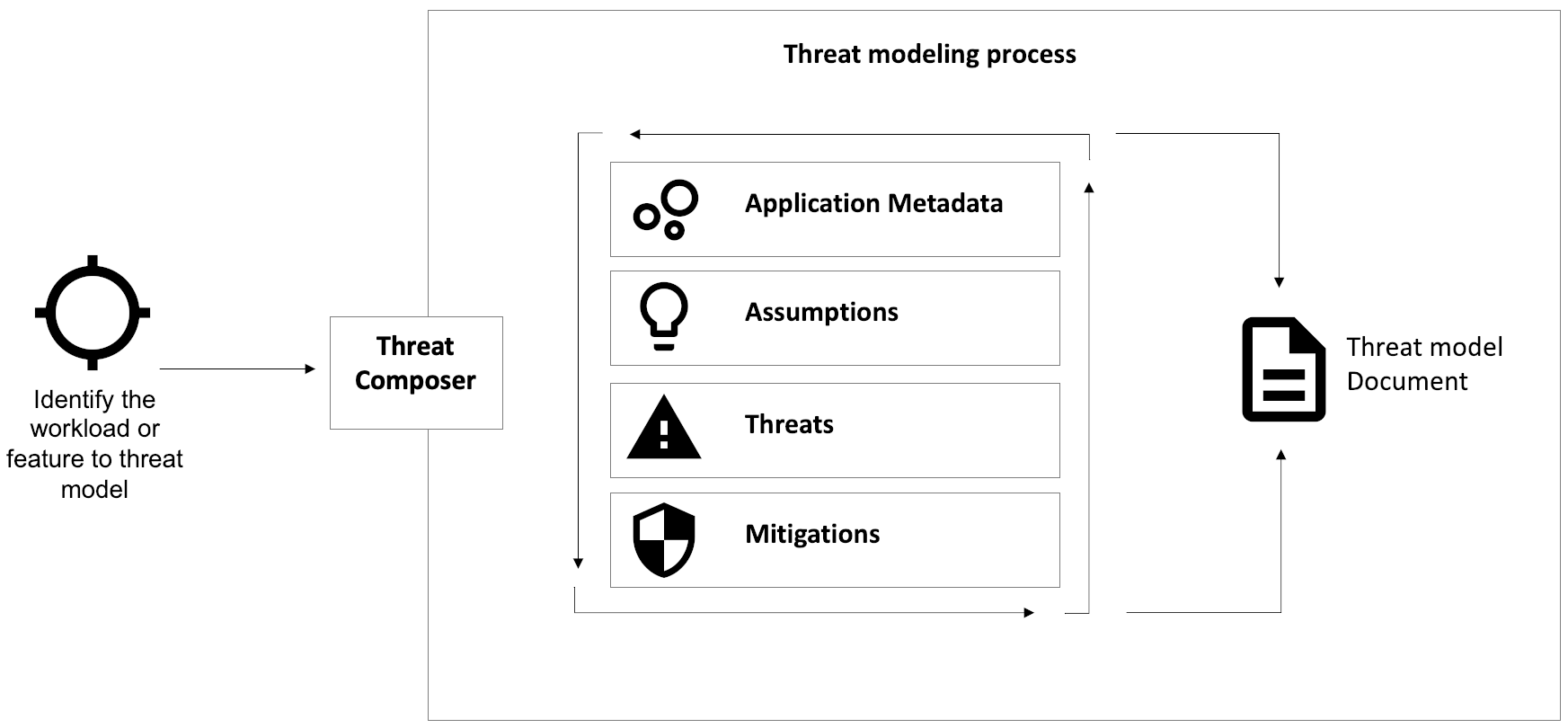

Цель данной статьи — подробно рассмотреть процесс моделирования угроз для рабочих нагрузок генеративного ИИ, основываясь на рекомендациях AWS и подходах инструмента Threat Composer.

1. Что такое моделирование угроз для генеративного ИИ?

Моделирование угроз (Threat Modeling) — это процесс идентификации, оценки и снижения рисков, связанных с использованием генеративных моделей. Этот подход необходим для понимания, как злоумышленники могут эксплуатировать системы, и создания стратегий защиты.

Почему это важно?

- Чувствительность данных: Генеративные модели часто обучаются на огромных наборах данных, которые могут включать конфиденциальную информацию.

- Угрозы конфиденциальности: Неправильная обработка запросов может привести к утечке данных пользователей или корпоративной информации.

- Злоупотребление: Модели могут быть использованы для создания вредоносного контента, таких как фальшивые новости или фишинговые письма.

2. Моделирование угроз с помощью Threat Composer

AWS предлагает инструмент Threat Composer, который помогает систематизировать анализ угроз для генеративного ИИ.

- Особенности инструмента:

- Автоматизация создания моделей угроз.

- Удобный интерфейс для управления рисками.

- Специфические «пакеты угроз» для генеративного ИИ, такие как сценарии для чат-ботов.

Пример пакета угроз: Generative AI Chatbot

Для генеративных чат-ботов Threat Composer выделяет следующие аспекты:

- Контекст использования:

- Модель обучается на корпоративных данных.

- Пользователи взаимодействуют с моделью через API или интерфейсы.

- Типы угроз:

- Утечка данных.

- Злоумышленное внедрение кода через запросы.

- Неправомерный доступ к внутренним данным.

- Рекомендации по защите:

- Внедрение ограничений на входные данные (input validation).

- Мониторинг активности и аномалий.

- Аутентификация и контроль доступа к API.

3. Основные угрозы для генеративного ИИ

3.1 Утечка конфиденциальной информации

Генеративные модели могут быть обучены на данных, содержащих конфиденциальную информацию, которая может случайно или умышленно оказаться в ответах модели.

Пример:

Модель возвращает данные, которые были использованы во время обучения, например, личные данные пользователей.

Меры защиты:

- Ограничить доступ к обучающим данным.

- Применять фильтры на выходные данные модели.

- Регулярно тестировать модель на утечку информации.

3.2 Атаки через пользовательские запросы (Prompt Injection)

Злоумышленники могут манипулировать запросами к модели, чтобы извлечь скрытую информацию или заставить её выполнять нежелательные действия.

Пример:

Запрос, содержащий вредоносные инструкции, может заставить модель раскрыть свои внутренние параметры или обучающие данные.

Меры защиты:

- Проводить строгую проверку входных данных.

- Использовать контекстные ограничения на запросы.

- Логировать и анализировать все взаимодействия с моделью.

3.3 Злоупотребление доступом

Неправильная настройка прав доступа может позволить посторонним использовать модель в ущерб компании.

Пример:

Публичный API с отсутствующей аутентификацией позволяет злоумышленникам получать доступ к модели.

Меры защиты:

- Внедрить многофакторную аутентификацию.

- Ограничить доступ по IP-адресам или геолокации.

- Регулярно проводить аудит прав доступа.

4. Рекомендации по безопасности

4.1 Обучение модели

- Убедитесь, что данные для обучения очищены от конфиденциальной информации.

- Используйте методы дифференциальной приватности для защиты данных.

- Документируйте источники данных, чтобы избежать использования запрещённых наборов.

4.2 Развёртывание модели

- Изолируйте рабочие нагрузки генеративного ИИ в защищённых средах.

- Ограничьте доступ к API через токены и политики безопасности.

- Реализуйте механизмы шифрования данных при передаче и хранении.

4.3 Мониторинг и управление

- Настройте системы мониторинга для выявления аномалий.

- Регулярно обновляйте модели и патчи безопасности.

- Проводите тесты на проникновение для выявления уязвимостей.

5. Будущее моделирования угроз

Сложность моделей ИИ требует постоянного совершенствования подходов к управлению рисками. Основные направления:

- Автоматизация анализа угроз: Интеграция Threat Composer с другими инструментами анализа поможет сократить время на оценку рисков.

- Использование ИИ для мониторинга: ИИ может анализировать огромные объёмы данных и выявлять аномалии быстрее человека.

- Обучение персонала: Внедрение программ повышения квалификации в области безопасности генеративного ИИ.

6. Примеры успешного использования методов моделирования угроз

Кейсы и реализация на практике

- Компания A: Защита конфиденциальных данных

Ситуация: Международная финансовая корпорация использовала генеративные модели для анализа пользовательских данных. При тестировании было выявлено, что модель может случайно возвращать конфиденциальную информацию, сохранённую в её обучающих данных.

Решение:- Были внедрены фильтры выходных данных для удаления потенциально конфиденциальной информации.

- Использовался инструмент Threat Composer, чтобы оценить риски и адаптировать модель к требованиям безопасности.

Результат: Значительно снизился риск утечки данных при взаимодействии с клиентами.

- Компания B: Борьба с атаками Prompt Injection

Ситуация: Вендор программного обеспечения разработал ИИ-чатбота для службы поддержки. В процессе эксплуатации выяснилось, что злоумышленники могут манипулировать запросами, чтобы вызвать у модели выполнение вредоносных команд.

Решение:- Реализованы контекстные ограничения на запросы.

- Внедрены системы журналирования всех взаимодействий для анализа подозрительных действий.

Результат: Уровень безопасности модели вырос на 30%, а случаи успешных атак снизились до нуля.

- Компания C: Контроль доступа к API

Ситуация: Публичный API с недостаточной аутентификацией позволял злоумышленникам бесконтрольно использовать ресурсы компании.

Решение:- Были настроены токены доступа и многофакторная аутентификация.

- Доступ ограничили по геолокации и IP-адресам.

Результат: API стал защищённым, а уровень попыток несанкционированного доступа сократился на 70%.

Заключение

Моделирование угроз — это не только инструмент, но и стратегический подход, позволяющий оценить и минимизировать риски, связанные с использованием генеративных моделей. Используя такие инструменты, как Threat Composer, компании могут обеспечить безопасность своих данных и предотвратить злоупотребления.

Безопасность генеративного ИИ — это динамическая задача, требующая постоянного анализа и улучшения. Только скоординированные действия разработчиков, администраторов и специалистов по безопасности помогут использовать потенциал этих технологий без риска для пользователей и организаций.