Недавние достижения в области ИИ и выпуск ChatGPT вызвали новый интерес к ИИ как инструменту. Агентные LLM — это последняя попытка создать узкоспециализированные ИИ и избежать их выхода из-под контроля.

Искусственный интеллект сегодня в моде, когда люди и организации спешат внедрить или использовать искусственный интеллект для повышения эффективности и прибыли. Но в мире искусственного интеллекта все еще существует одна назойливая проблема, которая с течением времени становится все более и более тревожной: выравнивание.

Согласование ИИ относится к процессу проектирования и внедрения систем ИИ таким образом, чтобы они соответствовали человеческим целям, ценностям и желаемым результатам. Другими словами, согласование связано с обеспечением того, чтобы ИИ не выходил из-под контроля.

Это зарождающаяся область искусственного интеллекта, и исследователи и разработчики, как правило, только начинают осознавать ее важность. За стремления к лучшей настройке ИИ стоят опасения, что ИИ выйдет из-под контроля и потенциально причинит вред или уничтожит человечество.

Разбиение задач искусственного интеллекта на составные

Одним из способов добиться рабочей настройки искусственного интеллекта, которая сохраняет как точность, так и согласованность, является композиция — концепция, взятая из мира программного обеспечения, в которой часть программного обеспечения создается путем сборки существующих компонентов для создания приложения или набора.

Выравнивание обычно используется, когда речь идет об обучении больших языковых моделей (LLM) для изучения конкретной области знаний — и периодической переподготовке этих моделей, когда они начинают отклоняться от курса.

Идея использования композиции в искусственном интеллекте состоит в том, чтобы разбить модели обучения на подзадачи, при этом каждая задача фокусируется на чем-то одном. Программное обеспечение в целом периодически проверяет выполнение каждой задачи, чтобы убедиться, что оно выполняет свою функцию — и только свою функцию.

Используя композицию для фокусирования задач обучения на чем-то одном, системы ИИ могут быть построены более надежными и точными, поддерживая соответствие подзадач и моделей желаемым целям.

Отражение, или reflexion

Один из способов научить модели искусственного интеллекта оставаться на задании — это дать им возможность использовать рефлексию, при которой модель или задача периодически проверяет себя, чтобы убедиться, что то, что она преследует, соответствует только ее цели. Если модель или задача начинает отклоняться от темы, программное обеспечение может периодически корректировать задачу, чтобы убедиться, что она остается сфокусированной.

Автономные агенты, управляемые задачами

Поскольку конечной целью согласования является точность и соблюдение границ, а поскольку композиция — хороший способ добиться этого, конечной целью является разработка системы агентов. Каждый агент становится экспертом предметной области по определенному предмету.

Агентные LLM и другие обычные агенты ИИ уже находятся в разработке, а в некоторых случаях уже выпущены, и вокруг объекта возникает целая экосистема агентов ИИ.

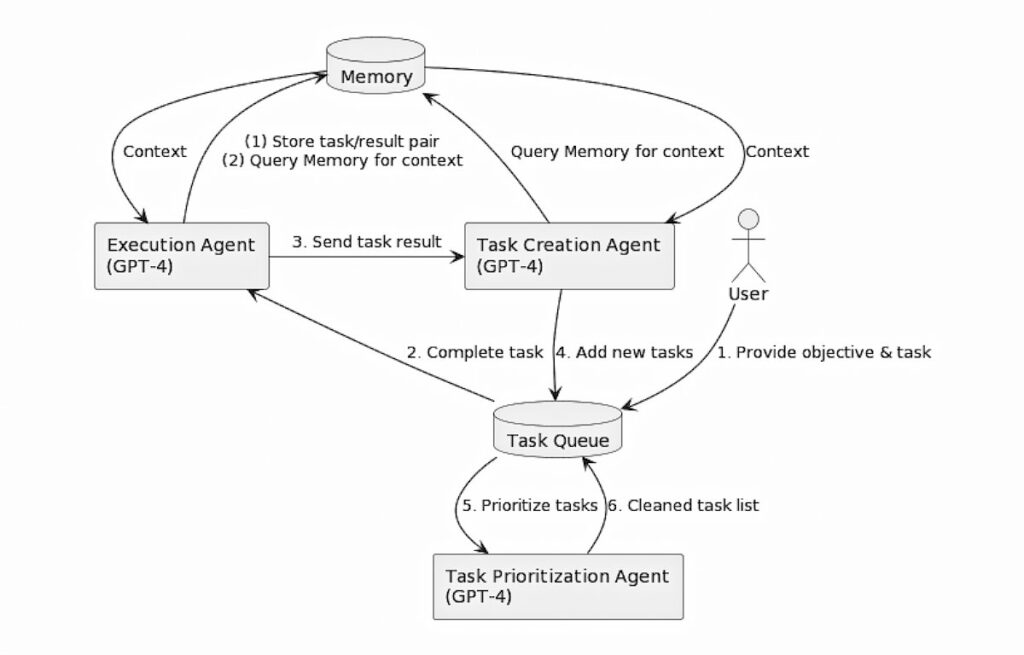

Исследователь искусственного интеллекта Йохей Накадзима опубликовал в своем блоге статью под названием «Автономный агент, управляемый задачами, использующий GPT-4, Pinecone и LangChain для различных приложений».

LangChain — это набор инструментов и агентов искусственного интеллекта, который помогает разработчикам создавать агентные LLM с помощью компоновки.

У Накадзимы также есть запись в блоге под названием «Восстание автономного агента». В статье Накадзимы показаны диаграммы одного из возможных способов работы управляемых LLM-систем:

Операционные системы агентов ИИ

e2b.dev выпустила EB2, которую она описывает как «Операционную систему для агентов искусственного интеллекта». Eb2.dev также опубликовал список «Потрясающих агентов искусственного интеллекта» на GitHub. Там также есть хранилище потрясающих SDK для агентов искусственного интеллекта.

В будущем мы можем представить системы искусственного интеллекта, которые можно изменять, просто изменяя, какие агенты и LLM выбираются для согласования, пока не будет достигнут желаемый результат. Возможно, мы увидим появление операционных систем-агентов искусственного интеллекта, которые будут решать эти задачи за нас.

Дополнительные ресурсы

В дополнение к вышеупомянутым ресурсам, также ознакомьтесь с центром инструментов искусственного интеллекта — в частности, с введением в выравнивание искусственного интеллекта: как заставить ИИ работать на благо человечества, а также с важностью выравнивания искусственного интеллекта, описанной в 5 пунктах на форуме по выравниванию искусственного интеллекта.

Также есть хорошая вводная статья по теме выравнивания ИИ под названием «Понимание исследований выравнивания ИИ: систематический анализ» Яна Х. Киршнера, Логана Смита, Жака Тибодо и др.

Еще одна интересная веб-компания-агент по ИИ, которую стоит проверить, — это Cognosys.

Нам придется подождать и посмотреть, что ждет ИИ в будущем, но работа над попытками снизить некоторые риски и потенциальные негативные аспекты, которые ИИ может принести со временем, уже идет полным ходом.