В современную цифровую эпоху, когда технологии пронизывают каждый аспект нашей жизни, важность кибербезопасности трудно переоценить. Киберугрозы становятся все более изощренными, что требует инновационных способов защиты конфиденциальных данных и предотвращения атак.

Генеративный искусственный интеллект (ИИ) превратился в мощный инструмент, способный преобразовать ландшафт кибербезопасности. В этой статье исследуется, как генеративный ИИ может произвести революцию в области кибербезопасности, предлагая новые возможности и решая проблемы обеспечения суверенитета данных.

Проблемы и решения использования ИИ в кибербезопасности

Искусственный интеллект (ИИ) имеет большие перспективы в области кибербезопасности, но он также несет с собой свой уникальный набор проблем и потенциальных рисков.

1. Качество данных и предвзятость

Одной из основных задач является обеспечение качества обучающих данных и устранение предвзятостей. Чтобы преодолеть эту проблему:

✨ Обеспечение разнообразия данных для минимизации предвзятости

В мире генеративного ИИ и кибербезопасности крайне важно гарантировать, что данные, используемые для обучения моделей искусственного интеллекта, разнообразны и репрезентативны. Это разнообразие охватывает различные аспекты, такие как различные типы киберугроз, векторы атак и демографические характеристики целей.

Используя широкий массив данных, мы можем свести к минимуму риск предвзятости, которая может привести к тому, что системы искусственного интеллекта будут выдавать неточные или несправедливые результаты. По сути, разнообразие данных об обучении служит гарантией от искажения результатов.

✨ Частые обновления и проверка данных обучения

Постоянно меняющийся ландшафт киберугроз требует, чтобы мы постоянно обновляли и проверяли наши учебные данные. Регулярно появляются новые методы атак, поэтому крайне важно поддерживать модели ИИ в актуальном состоянии.

Регулярно обновляя набор данных, мы гарантируем, что система искусственного интеллекта обучена новейшим данным об угрозах. Более того, механизмы валидации помогают проверять точность и актуальность обучающих данных, гарантируя, что они остаются надежной основой для нашей защиты от искусственного интеллекта.

✨ Внедрение предварительной обработки данных для уменьшения предвзятости

Методы предварительной обработки данных играют ключевую роль в устранении искажений и повышении качества данных. Эти методы включают тщательную очистку, фильтрацию и нормализацию данных перед их подачей в модели искусственного интеллекта. Поступая таким образом, мы можем выявлять и исправлять потенциальные искажения, присутствующие в данных.

Например, предварительная обработка может помочь устранить выбросы, исправить дисбалансы и обеспечить единообразное представление точек данных. Эта тщательная подготовка гарантирует, что система ИИ будет обучена на чистом и непредвзятом наборе данных, что приведет к более точным и справедливым результатам.

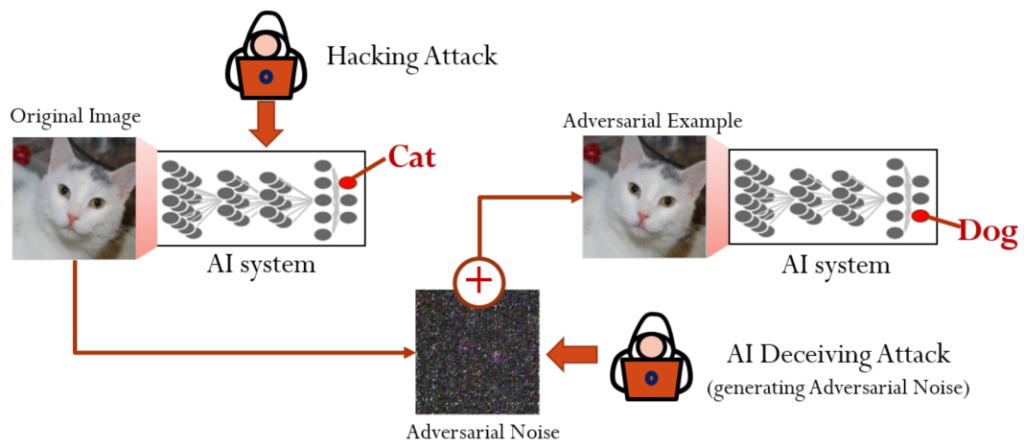

2. Состязательные атаки

Состязательные атаки представляют значительную угрозу для генеративных моделей ИИ. Снизить этот риск:

✨ Внедрение надежных механизмов обнаружения и защиты от противодействия

Когда речь заходит о кибербезопасности, термин “состязательный” относится ко всему, что связано со злонамеренными или враждебными намерениями. Когда дело доходит до генеративного ИИ, состязательные атаки включают попытки обмануть системы ИИ или манипулировать ими. Для защиты от таких угроз крайне важно внедрить надежные механизмы обнаружения и защиты от противодействия.

Эти механизмы действуют как первая линия защиты от злоумышленников, стремящихся использовать уязвимости в системах искусственного интеллекта. Они работают путем выявления шаблонов или моделей поведения во входных данных, которые указывают на потенциальную враждебную атаку. После обнаружения система искусственного интеллекта может принять превентивные меры для смягчения или нейтрализации угрозы.

Внедряя эти механизмы обнаружения и защиты, организации могут значительно снизить риск враждебных атак, ставящих под угрозу целостность и эффективность их систем искусственного интеллекта. Это сродни бдительному часовому, охраняющему ворота, готовому выявить и отразить любые потенциальные угрозы.

✨ Регулярное тестирование устойчивости модели к атакам противника

Киберугрозы постоянно развиваются, и постоянно разрабатываются новые тактики противодействия. Чтобы опережать эти угрозы, организациям следует регулярно проверять устойчивость своих моделей генеративного ИИ к атакам противника.

Это тестирование включает в себя намеренное подвергание моделей ИИ различным сценариям противостояния, чтобы оценить их эффективность под давлением. Поступая таким образом, организации могут выявлять потенциальные слабые места, которыми могут воспользоваться киберпреступники.

Выводы, полученные в результате этих тестов, бесценны для повышения защищенности системы искусственного интеллекта. Это позволяет командам по кибербезопасности понять, как противники могут попытаться подорвать работу искусственного интеллекта, и разработать соответствующие контрмеры.

✨ Внедрение методов состязательного обучения для повышения надежности

Состязательное обучение — это упреждающая стратегия, которая включает в себя ознакомление моделей искусственного интеллекта с примерами состязательности в процессе их обучения. Это знакомство помогает моделям научиться распознавать враждебные атаки и адаптироваться к ним, тем самым повышая их надежность.

Во время состязательного обучения модели ИИ неоднократно сталкиваются с данными, которые были тонко изменены, чтобы обмануть систему. По мере того, как модель сталкивается с этими состязательными примерами, она учится распознавать их и эффективно реагировать.

Внедрение методов состязательного обучения при разработке модели гарантирует, что система искусственного интеллекта проверена в боевых условиях и лучше оснащена для защиты от реальных состязательных атак. Это сродни предоставлению ИИ “учебных упражнений” для оттачивания его способности обнаруживать попытки злоумышленников и противодействовать им.

3. Потребности в ресурсах

Модели генеративного ИИ часто требуют значительных вычислительных ресурсов. Для решения этой задачи:

✨ Оптимизация моделей генеративного ИИ

Оптимизируйте модели и алгоритмы искусственного интеллекта для достижения высокой производительности при снижении вычислительных требований.

✨ Использование облачных ресурсов

Используйте облачные ресурсы и распределенные вычислительные платформы для эффективного обучения и развертывания моделей.

✨ Непрерывный мониторинг ресурсов

Постоянный мониторинг и оценка использования ресурсов для обеспечения экономической эффективности и масштабируемости систем искусственного интеллекта.

4. Интерпретируемость и объяснимость

Понимание того, как модели генеративного ИИ принимают решения, имеет решающее значение для доверия и подотчетности. Решения включают:

✨ Повышение интерпретируемости и объяснимости

В сфере ИИ и кибербезопасности решающее значение имеет понимание того, почему система ИИ принимает то или иное решение. Это понимание не только укрепляет доверие, но и помогает специалистам по кибербезопасности эффективно интерпретировать результаты, сгенерированные ИИ.

Повышенная интерпретируемость и объяснимость относятся к способности моделей ИИ предоставлять четкие, понятные человеку объяснения своих результатов. Он позволяет пользователям проследить, как ИИ пришел к конкретному решению, что облегчает выявление потенциальных проблем или ошибок.

Это особенно важно в сфере кибербезопасности, где ИИ используется для обнаружения угроз и принятия решений, которые могут иметь значительные последствия. Интерпретируемая система ИИ может дать представление о том, почему она пометила определенную активность как подозрительную, позволяя экспертам по кибербезопасности предпринять соответствующие действия.

✨ Обобщение моделей и извлечение правил

Обработка моделей и извлечение правил — это методы, используемые для упрощения сложных моделей ИИ при сохранении их основной функциональности и возможностей принятия решений.

Переработка модели включает в себя обучение более простой и интерпретируемой модели для имитации поведения сложной модели. Эта переработанная модель проще для понимания и может служить прозрачным представлением исходной модели.

Извлечение правил, с другой стороны, включает в себя извлечение удобочитаемых правил или деревьев решений из сложной модели. Эти правила дают четкое представление о том, как модель принимает решения, облегчая специалистам по кибербезопасности понимание ее результатов и доверие к ним.

Эти методы особенно полезны при работе со сложными генеративными моделями ИИ. Упрощая их, организации могут достичь баланса между точностью и прозрачностью, гарантируя, что решения ИИ будут надежными и понятными.

✨ Включение прозрачности и интерпретируемости в проектирование и оценку

Прозрачность и интерпретируемость должны быть неотъемлемыми факторами при проектировании и оценке систем генеративного ИИ с самого начала. Это означает, что организации должны уделять приоритетное внимание этим аспектам в процессе разработки.

Проектирование систем ИИ с учетом прозрачности предполагает использование алгоритмов и архитектур, которые по своей сути дают интерпретируемые результаты. Это также включает создание интерфейсов, позволяющих пользователям взаимодействовать с ИИ способом, способствующим взаимопониманию.

На этапе оценки организациям следует оценить интерпретируемость и объяснимость своих моделей ИИ. Это может включать проведение тестов и аудитов, чтобы убедиться, что решения ИИ соответствуют целям кибербезопасности и могут быть легко поняты людьми-операторами.

5. Интеграция и совместимость

Обеспечение беспрепятственной интеграции генеративного ИИ с существующей инфраструктурой кибербезопасности имеет решающее значение. Для достижения этой цели:

- Учитывайте требования к совместимости и интероперабельности при проектировании и выборе генеративных систем ИИ.

- Стимулируйте сотрудничество между ИИ и командами по кибербезопасности для обеспечения плавной интеграции с существующими инструментами безопасности и рабочими процессами.

- Разработка стандартных форматов данных и API для бесшовной интеграции с существующей инфраструктурой кибербезопасности.

Использование ИИ для обнаружения кибератак

Генеративный ИИ предлагает многообещающие пути улучшения обнаружения кибератак, особенно на этапе идентификации систем реагирования на инциденты. Давайте разберемся, как генеративный ИИ позволяет специалистам по кибербезопасности оставаться на шаг впереди киберпреступников.:

1. Расширенное обнаружение угроз

Генеративный ИИ дополняет традиционные системы безопасности, изучая шаблоны и поведение на основе обширных наборов данных. Это позволяет ИТ-отделу выявлять аномалии и потенциальные угрозы, которые могут обойти обычные системы. Непрерывный анализ потоков данных позволяет генеративному ИИ обнаруживать малозаметные признаки вредоносной активности, обеспечивая раннее предупреждение специалистам по кибербезопасности.

2. Адаптивные системы защиты

Адаптивность генеративного ИИ является значительным преимуществом. В отличие от традиционных систем с заранее определенными правилами, он извлекает уроки из новых векторов атак и динамически корректирует свою защиту. Такая адаптивность позволяет ИТ-отделу опережать развивающиеся киберугрозы, эффективно смягчая возникающие уязвимости.

3. Автоматическое реагирование на инциденты

Реагирование на инциденты имеет решающее значение, но может перегружать операторов-людей из-за сложности атак. Генеративный ИИ автоматизирует различные этапы реагирования на инциденты, анализируя и расставляя приоритеты событий безопасности, классифицируя инциденты и предлагая стратегии реагирования. Эта автоматизация освобождает специалистов по кибербезопасности, позволяя им сосредоточиться на сложных задачах, увеличивая время реагирования и общую безопасность.

4. Усовершенствованный анализ угроз

Генеративный ИИ улучшает анализ угроз за счет обработки больших объемов данных из различных источников. Используя обработку естественного языка и алгоритмы машинного обучения, он извлекает ценную информацию и выявляет новые тенденции. Это позволяет организациям активно защищать свои системы и сети.

5. Интеллектуальная аутентификация пользователя

Генеративный ИИ усиливает аутентификацию пользователей за счет анализа моделей поведения, биометрических данных и контекстуальной информации. Такой подход усиливает системы аутентификации, делая их более устойчивыми к олицетворению и несанкционированному доступу.

Обоюдоострый меч генеративного ИИ

Хотя генеративный ИИ предлагает огромные преимущества для кибербезопасности, он также может быть использован кибератакующими в качестве инструмента. Он позволяет создавать более убедительные фишинговые электронные письма, видео-подделки и модифицированный код атаки. Поэтому необходимы бдительность и инновации, чтобы опережать противников.

Этические соображения и ответственное использование

Этические соображения касаются конфиденциальности данных и ответственного использования генеративного ИИ. Организации должны гарантировать, что данные, собираемые и обрабатываемые этими системами, осуществляются с согласия пользователей и в соответствии с соответствующими нормативными актами. Прозрачность и этичное использование ИИ необходимы для укрепления доверия.

Заключительные выводы

Генеративный ИИ обладает огромным потенциалом в преобразовании кибербезопасности. Используя возможности машинного обучения для обнаружения аномалий, анализа поведения и анализа угроз, он позволяет специалистам по кибербезопасности быстро реагировать на потенциальные угрозы, включая угрозы изнутри, эффективно снижая риски.

Однако ответственное внедрение и бдительные этические соображения жизненно важны для обеспечения безопасного и ответственного использования generative AI в нашем стремлении создать более безопасный цифровой мир. По мере развития технологий роль генеративного ИИ в кибербезопасности будет продолжать расти.

Внедрение ИИ для кибербезопасности может переопределить будущее кибербезопасности и обеспечить безопасное цифровое будущее для всех.

Защитите свое цифровое пространство с помощью решений Exabytes в области кибербезопасности!

В эпоху развития цифровых угроз обеспечьте защиту вашей сети, данных и приложений с помощью наших комплексных решений в области кибербезопасности! От сетевой до облачной безопасности, защиты конечных точек и предотвращения DDoS-атак, Exabytes обеспечивает надежную защиту ваших цифровых активов, гарантируя, что они остаются невосприимчивыми к несанкционированному доступу и угрозам.